IT之家1月25日消息,AMD宣布,已将新的DeepSeek-V3模型集成到InstinctMI300XGPU上,该模型经过SGLang强化,针对Al推理进行了优化。

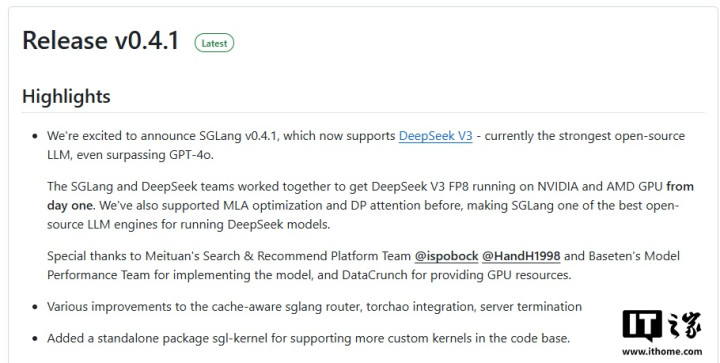

IT之家查询发现,AMD早在去年12月26日就在Github上公布了支持DeepSeek-V3模型的SGLangv0.4.1。

AMD表示,DeepSeekV3是目前最强的开源LLM,甚至超过了GPT-4o。AMD还透露,SGLang和DeepSeek团队通力合作,使DeepSeekV3FP8从首发当天就能在英伟达和AMDGPU上运行。此外,AMD还感谢了美团搜索与推荐算法平台团队以及DataCrunch提供GPU资源。

据介绍,DeepSeek-V3模型是一个强大的混合专家(MoE)语言模型,总参数量为671B,每个token激活37B参数。

为了实现高效推理和高经济效益的训练,DeepSeek-V3采用了多头潜在注意力(MLA)和DeepSeekMoE架构。

此外,DeepSeek-V3开创了一种无辅助损失的负载平衡策略,并设置了多标记预测训练目标以实现更强劲的性能。

DeepSeek-V3使开发人员能够使用高级模型,利用内存能力同时处理文本和视觉数据,让开发人员可以广泛获取先进功能,并为其提供更多功能。

AMDInstinctGPU加速器和DeepSeek-V3

AMD表示,ROCm中广泛的FP8支持可显著改善运行AI模型的过程,尤其是在推理方面。它有助于解决诸如内存瓶颈和与更多读写格式相关的高延迟问题等关键问题,使平台能够在相同的硬件限制下处理更大的模型或批处理,从而带来更高效的训练和推理过程。

此外,FP8降低精度计算可以减少数据传输和计算中的延迟。AMDROCm扩展了其生态系统中对FP8的支持,从而能够在各个方面(从框架到库)改善性能和效率。